cursor官方并不原生支持本地LLM部署,需要通过openai_api_key来实现。

Ollama配置

- 前往ollama 官网 下载应用程序

- 下载一个模型

ollama pull llama3.3

Ngrok 设置

- 下载并安装 Ngrok

- 按照提示获取您的免费账户以及token

- 在终端中,运行:

ngrok config add-authtoken <token> - 启动ngrok,运行:

ngrok http 11434 --host-header="localhost:11434"

OpenAI API 设置

- 前往Openai API Key 生成一个新的 API 密钥

- 随便命名,我用的名字是"ollama"

- 复制密钥

Cursor IDE配置

-

打开Cursor Settings

-

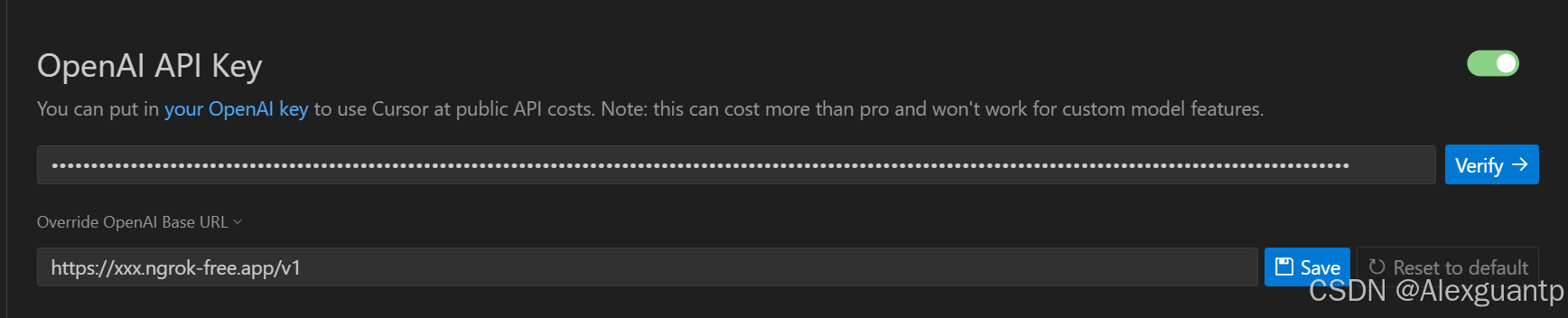

向下滚动到 OpenAI API Key 部分,并启用它

-

粘贴 OpenAI API 密钥到剪贴板,然后点击验证

-

前往运行 Ngrok 的终端,并复制自动生成的转发 URL

-

将 URL 粘贴到覆盖 OpenAI 基本 URL 字段中,然后点击保存,URL 的格式类似于

https://***.ngrok-free.app

-

注意:每次重启 Ngrok 时,您都需要将此 URL 复制到覆盖 OpenAI 基础 URL,因为转发 URL 总是不同的

-

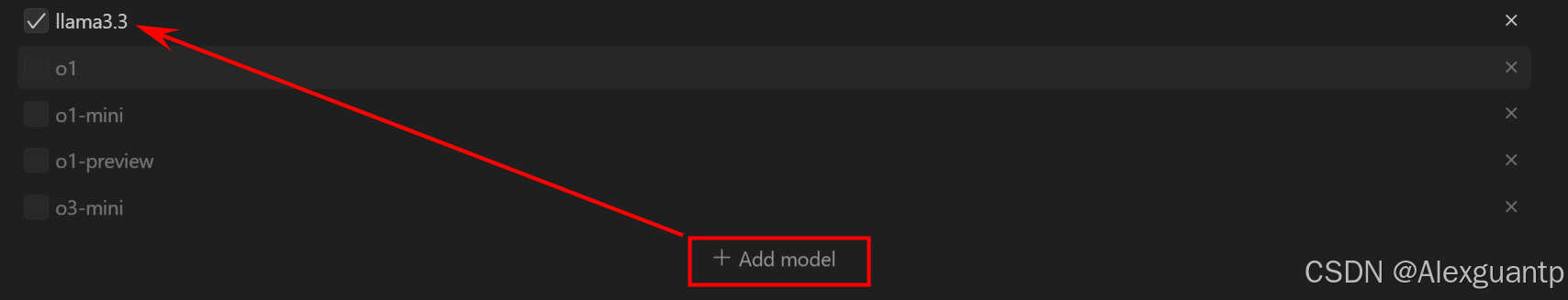

添加一个模型,并将其命名为你拉取的 Ollama 模型的确切名称。在我们的示例中,我们使用了 llama3.3。可以通过

ollama list查看模型名称并添加

-

切换 AI 面板,然后在聊天提示面板中输入您的 AI 提示。它应该开始与刚刚配置的 Ollama 本地LLM进行交互